Opublikowano: 19.10.2022 13:01

Pomysł studenta PW pomoże w tworzeniu map na podstawie zdjęć satelitarnych

Wszechobecne samochody są wyzwaniem przy organizacji ruchu w miastach. Utrudniają także pracę nad mapami, które powstają z obrazów pochodzących z satelitów. Szymon Bogus z Wydziału Mechanicznego Energetyki i Lotnictwa Politechniki Warszawskiej znalazł rozwiązanie tego problemu. Kluczem do sukcesu okazała się sztuczna inteligencja.

– Przy wykorzystaniu dwóch modeli głębokiego uczenia udało mi się wykryć i usunąć samochody ze zdjęć satelitarnych oraz zrekonstruować obraz tak, aby miejsce aut zastąpić tym, co powinno się pod nimi znajdować – opowiada nasz student.

Samochody, które się poruszają, stoją zaparkowane albo w korkach, często zasłaniają, jak rzeczywiście wygląda dany obszar. Tym samym niemożliwe jest zdobycie pełnej informacji o terenie. To realny problem przede wszystkim w dużych miastach.

– Dzięki sprawnej, automatycznej podmianie auta na obraz tego, co znajduje się pod nim, możemy korzystać ze zdjęć wykonanych w godzinach szczytu i nie martwić się, że nie dostrzeżemy interesujących nas cech infrastruktury miejskiej – wyjaśnia Szymon Bogus.

Projekt składał się z dwóch zadań: segmentacji obrazu oraz jego rekonstrukcji.

W pierwszym etapie trzeba było rozróżnić dwie klasy obiektów: samochody i tło. Tu pojawiło się pierwsze wyzwania – auta na zdjęciach satelitarnych to bardzo małe elementy, tło jest z kolei bardzo zróżnicowane, obejmuje zarówno niewielkie obrazy, jak i duże przestrzenie.

– Żadne klasyczne algorytmy takie jak K-Nearest Neighbors czy K-Means Clustering nie poradzą sobie z taką segmentacją – wyjaśnia Szymon Bogus. – Dlatego kluczowe było użycie konkretnego modelu głębokiego uczenia się – takiego, który pozwalał zrozumieć, w jaki sposób samochód wygląda na zdjęciach satelitarnych.

Drugi etap obejmował przewidywanie, jaka powierzchnia znajdowała się pod samochodem, zanim ten został usunięty ze zdjęcia.

– Do tego niezbędna była analiza otoczenia pojazdów, poszukiwanie w nim powtarzających się wzorców, krawędzi o różnych cechach i rozkładu kolorów – opowiada student Politechniki Warszawskiej.

Wszystkie te funkcjonalności łączy inpaiting. Jego celem jest rekonstrukcja obrazów uszkodzonych. To zadanie także zostało wykonane przy pomocy techniki głębokiego uczenia się.

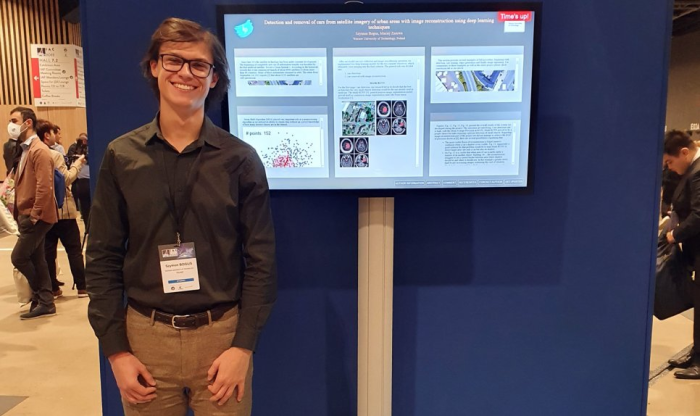

Rozwiązanie opracowane przez Szymona Bogusa powstało w ramach projektu dydaktycznego pt. „Development of an Improved Educational Curriculum with Focus on Artificial Intelligence in Aerospace Industry”, sponsorowanego przez The Boeing Company. Kierownikiem projektu był dr inż. Maciej Zasuwa z Wydziału Mechanicznego Energetyki i Lotnictwa PW. Efekt prac nasz student prezentował na Międzynarodowym Kongresie Astronautycznym, który odbył się we wrześniu w Paryżu.

Modele zostały wykorzystane do usuwania samochodów i rekonstrukcji obrazów, ale są tak uniwersalne, że na tym ich potencjalne zastosowania się nie kończą.

– Połączenie segmentacji i inpaintingu może służyć jako narzędzie do zaawansowanych misji obserwacji Ziemi – przekonuje Szymon Bogus. – Opracowane modele można precyzyjnie dostosować do pracy z różnymi obiektami, np. budynkami czy samolotami, co sprawia, że całe rozwiązanie jest bardzo wszechstronne.

Podobne tematy: